LangChain, LangGraph i LangFlow: Co To Takiego?

Wraz z dużymi modelami językowymi (LLM) szybko kształtującymi aplikacje oparte na sztucznej inteligencji, programiści potrzebują niezawodnych szkieletów oprogramowania, aby usprawnić złożone zadania, zorganizować integrację danych i zapewnić responsywne interakcje użytkowników. LangChain, LangGraph i LangFlow to trzy szkielety oprogramowania zaprojektowane specjalnie w celu uproszczenia tego procesu. Każdy z nich służy odrębnemu celowi, pomagając programistom tworzyć bardziej solidne, przyjazne dla użytkownika aplikacje, które wykorzystują potencjał LLM.

Ten artykuł rozpoczyna serię, w której przeprowadzę Cię przez korzystanie z LangChain, LangGraph i LangFlow. Tutaj przyjrzymy się tym szkieletom, podkreślając ich unikalne cechy i pokazując, kiedy każda z nich najlepiej pasuje do Twoich projektów.

Czym jest LangChain?

LangChain to szkielet oprogramowania o otwartym kodzie źródłowym, który umożliwia programistom tworzenie złożonych, zintegrowanych z danymi aplikacji z LLM w centrum. Oferuje szeroki zakres narzędzi i abstrakcji, które pomagają łączyć LLM z różnymi źródłami danych, interfejsami API i systemami zarządzania pamięcią. Ten szkielet oprogramowania jest szczególnie przydatny podczas tworzenia aplikacji wymagających głębokich interakcji konwersacyjnych, takich jak chatboty lub silniki rekomendacji. LangChain obsługuje funkcje takie jak łańcuchowanie modeli, zarządzanie pamięcią i "prompt engineering" — funkcje, które są kluczowe podczas tworzenia aplikacji wymagających kontekstowych odpowiedzi opartych na wcześniejszych interakcjach lub szczegółowych danych wejściowych użytkownika.

Na przykład programista tworzący spersonalizowanego asystenta zdrowia może użyć LangChain do utrzymania pamięci poprzednich rozmów, odpowiadania na określone zapytania związane ze zdrowiem i integracji z interfejsami API danych zdrowotnych w celu uzyskania dokładnych rekomendacji. Skupienie LangChain na ułatwianiu integracji danych i pamięci konwersacyjnej sprawia, że jest to potężny wybór podczas tworzenia aplikacji, które opierają się na ciągłości, personalizacji i zróżnicowanych danych wejściowych.

Czym jest LangGraph?

LangGraph został zaprojektowany, aby zapewnić modułowość i kontrolę aplikacjom, które wymagają bardziej wyrafinowanych struktur logicznych. Zamiast skupiać się wyłącznie na łańcuchowaniu wyników modelu, LangGraph wykorzystuje graficzne podejście oparte na węzłach, aby pomóc programistom w mapowaniu złożonych, opartych na logice przepływów pracy i ścieżek decyzyjnych. Ta elastyczność pozwala na lepszą wizualizację i organizację logiki aplikacji, dzięki czemu LangGraph jest idealnym wyborem dla projektów wymagających wieloetapowego rozumowania, odpowiedzi warunkowych lub ustrukturyzowanego podejmowania decyzji.

Na przykład zautomatyzowany system obsługi klienta, który musi kierować zapytania na podstawie profili klientów, wcześniejszych interakcji i konkretnych problemów, może używać LangGraph do tworzenia węzłów reprezentujących każdą potencjalną podróż użytkownika. Każdy węzeł może reprezentować inny punkt decyzyjny lub zapytanie, łącząc integracje danych i bramki logiczne. Ustrukturyzowane podejście LangGraph pomaga zmniejszyć złożoność ścieżek warunkowych i przepływów logicznych, zapewniając, że wszystkie punkty decyzyjne są łatwe do wizualizacji, aktualizacji i utrzymania w miarę rozwoju aplikacji.

Czym jest LangFlow?

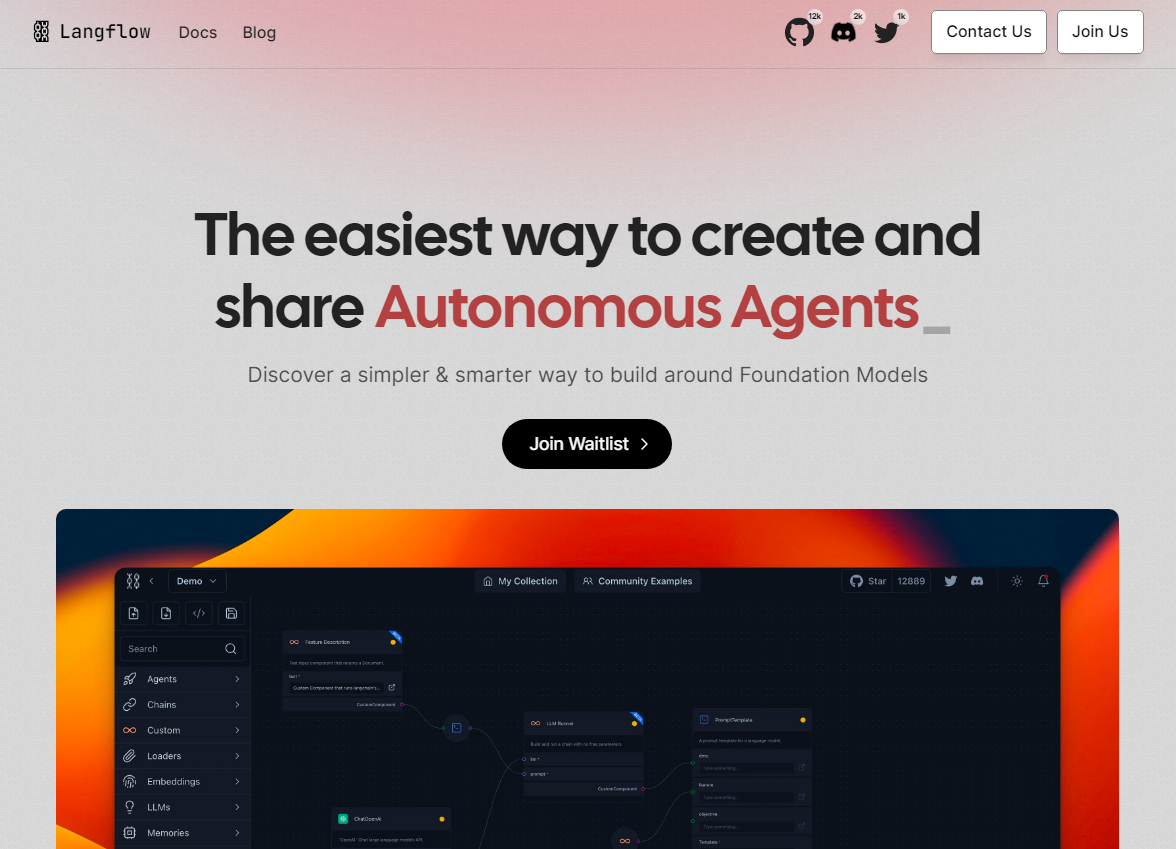

LangFlow oferuje interfejs wizualny typu „przeciągnij i upuść”, który ułatwia tworzenie, testowanie i modyfikowanie przepływów pracy z LLM. Dzięki intuicyjnemu projektowi LangFlow jest dostępny zarówno dla programistów, jak i osób niebędących programistami, oferując szybki sposób prototypowania aplikacji lub eksperymentowania z przepływami pracy opartymi na LLM. To narzędzie umożliwia użytkownikom konfigurowanie węzłów, zarządzanie źródłami danych i tworzenie ścieżek konwersacyjnych w przyjaznym dla użytkownika środowisku bez rozległego kodowania.

Załóżmy, że zespół tworzący treści chce skonfigurować automatycznego asystenta burzy mózgów. Mogą używać LangFlow do mapowania monitów, integrowania źródeł treści i dostosowywania przepływów pracy w locie. W miarę pojawiania się nowych pomysłów i wzorców logicznych użytkownicy mogą łatwo modyfikować węzły i ścieżki, dostosowując zachowanie LLM do konkretnych potrzeb generowania treści. Nacisk LangFlow na dostępność i szybkie prototypowanie pozwala zespołom eksperymentować z przepływami pracy i udoskonalać je w miarę nauki, co czyni je idealnym rozwiązaniem dla aplikacji wymagających ciągłych aktualizacji lub początkowo tworzonych przez zespoły nietechniczne.

Wybór odpowiedniego szkieletu oprogramowania

Wybór między LangChain, LangGraph i LangFlow zależy od konkretnych potrzeb Twojego projektu:

- Wybierz LangChain, jeśli Twoja aplikacja wymaga dynamicznych odpowiedzi opartych na zróżnicowanych źródłach danych, takich jak interfejsy API lub bazy danych, i musi zachować ciągłość konwersacji. Ta struktura jest najlepsza dla aplikacji, w których personalizacja, dogłębne interakcje i złożone integracje danych są kluczowe, takich jak chatboty, silniki rekomendacji i inteligentni asystenci osobiści.

- Wybierz LangGraph, jeśli Twój projekt wymaga zaawansowanej logiki, przepływów pracy opartych na decyzjach lub procesów wieloetapowych. Oparta na węzłach struktura LangGraph oferuje przejrzysty sposób wizualizacji i zarządzania złożonym rozumowaniem, dzięki czemu idealnie nadaje się do kierowania obsługą klienta, warunkowych przepływów pracy lub dowolnego systemu, który w dużym stopniu opiera się na ustrukturyzowanym podejmowaniu decyzji.

- Wybierz LangFlow, jeśli Twoimi głównymi potrzebami są dostępność i wizualny projekt przepływu pracy, szczególnie podczas prototypowania lub pracy z zespołami nietechnicznymi. Interfejs typu „przeciągnij i upuść” LangFlow pozwala zespołom na szybkie eksperymentowanie i udoskonalanie przepływów pracy, dzięki czemu doskonale nadaje się do tworzenia treści, mapowania doświadczeń klientów lub wszelkich aplikacji wymagających iteracyjnego projektowania.

Źródła